本記事は、ARスタートアップのOnePlanetにXRエンジニアとして所属し、様々なAR開発を手がける徳山より、2024年6月に日本で発売された Apple Vision Pro についての概要をまとめた内容となっています。

ARに特化したスタートアップである株式会社OnePlanetは、日本ではまだ発売前の2024年2月にApple Vision Pro を活用した日本初となるイベントを渋谷のパルコで手がけており、他では体験できない感動レベルの空間体験が大きな話題を集めました。

本記事では、Apple Vision Proの価格やできることを知りたい方向けに、デバイスの全体像やおもな特徴を整理して記載していきます。

目次

「Apple Vision Pro(アップル ビジョンプロ)」とは

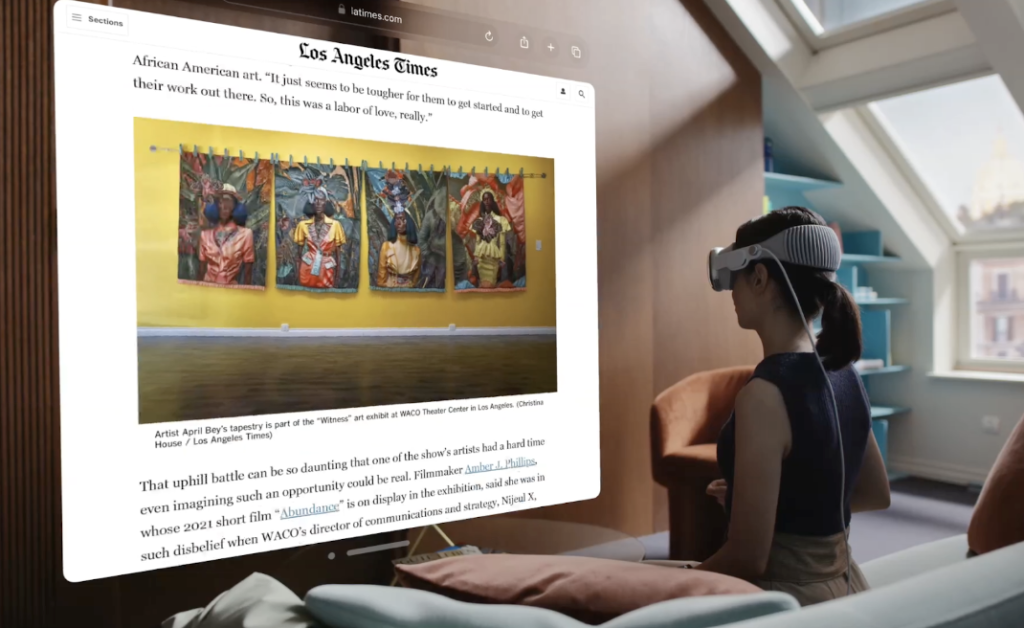

アップルグラスというARグラスの開発が噂されていた「Apple Vision Pro」は、Appleが開発したApple初の空間コンピューターです。現実の世界とデジタルの世界をシームレスに融合し、拡張現実と没入体験を提供します。

空間全体が境界のないディスプレイになります。空間に配置されたWebブラウザや他のアプリを使用することができます。また、写真やビデオを撮影し、大切な想い出を何度も体験できます。家族、友人、仕事仲間と一緒に同じ空間を共有してつながることもできます。

操作方法(コントロール)

「Apple Vision Pro」はマウスやコントローラーは存在せず、目、手、声を使って操作します。アプリのアイコンに視線を合わせると、視線が合ったアイコンが浮かび上がり、選択している状態になります。

選択や決定の操作は指同士をタップし、指を上下することでスクロール。そして入力フィールドを見つめたまま話すと、音声入力が始まるようになっています。Siriを使ってアプリの開閉やメディアの再生ができます。

Apple Vision Pro の体験シーン

Apple Vision Pro に搭載している3Dカメラで空間ビデオや空間写真を撮影して何度も体験することができます。空間ビデオについて以下の記事をご覧ください。

Apple Vision Pro の Digital Crownで調整して、現実の空間からバーチャルの空間に変貌させることができます。目の前の巨大スクリーンと空間オーディオに包まれながら、映画やテレビ番組、スポーツを観戦したり、ゲームを楽しんだりすることができます。空間オーディオと3Dビデオを組み合わせた立体動画を鑑賞することもできます。

特大スクリーンで100本以上のApple Arcadeゲームをプレイすることもできます。Apple Vision Pro と Macを接続すると、Mac の画面が空間ディスプレイとして表示されます。Apple Vision Pro に Magic Trackpad や Magic Keyboard と接続して作業することができます。

Apple Vision Proは、App StoreにリリースされたiPhoneやiPadのアプリを使用できる互換モードを搭載しています。これは、iPhoneやiPad向けに開発されたアプリが、そのままApple Vision Pro上でも動作する利点です。 互換モードで動作するアプリは、画面のデザインがiPad版で表示され、visionOSのShared Spaceのアプリとして動作します。

つまり、iPhoneやiPadにインストールしているマップアプリやカレンダーアプリなど、既にApp Storeに公開されているiPhoneアプリやiPadアプリが、互換モードで動作する要件を満たしていれば、自動的にApple Vision Pro対応のアプリとしてApp Storeに公開されます。このため、Apple Vision Proに対応したアプリは既に100万本以上存在します。

先行して開発されたアプリの紹介

先行して、既に数人の開発者がVision Proを使ったアプリを開発しています。JigSpaceは、デザイナーがF1デザインのコンセプトの検討やアイデアなど、製品を全く新しい方法で簡単に伝えることができるアプリケーションを開発しました。

以下のdjayアプリもApple Vision Proに対応。インターフェースが空間コンピューター向けに一新。誰でも目と手だけで好きな音楽をミックスし、リアルタイムでエフェクトをかけることができます。

AppleのARグラスで様々なアプリが体験できる様子に実感が湧いて、非常にワクワクしますね。

価格やスペックについて

ここからはApple Vision Pro および 周辺アイテムの価格や、ハードウェアのスペックについて解説していきます。

価格

256GB – 599,800円(税込)

512GB – 634,800円(税込)

1TB – 669,800円(税込)

Apple Vision Proトラベルケース – 34,800円(税込)

AppleCare+ for Apple Vision Pro – 89,800円(税込)

ZEISS Optical Inserts — Readers – 16,800円(税込)

ZEISS Optical Inserts — Prescription – 24,800円(税込)

ハードウェアのスペック

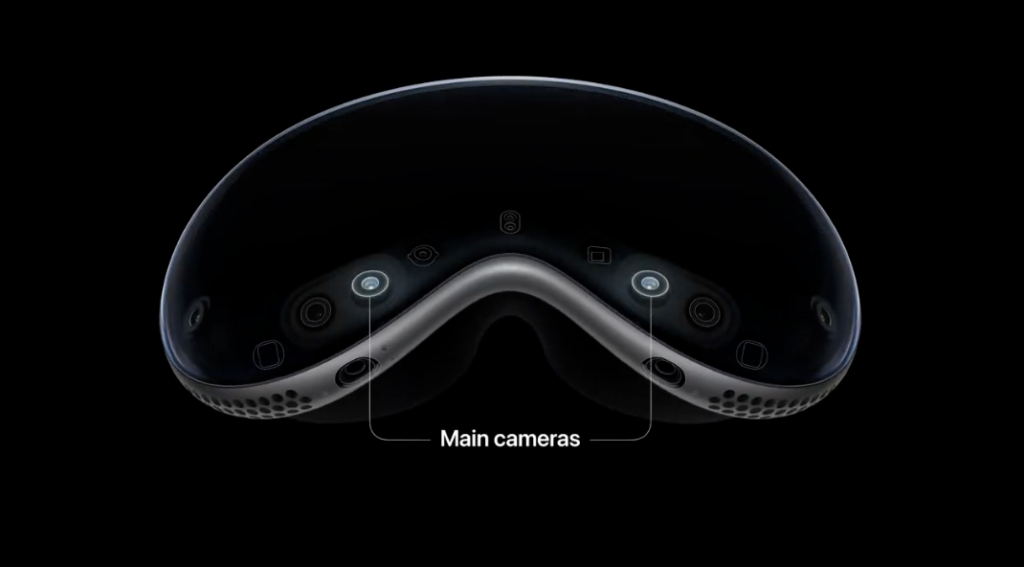

Apple Vision Pro は、2つのカメラを搭載されています。このカメラから高解像度の映像をディスプレイに届けます。

下部にカメラ、赤外線イルミネーター、サイドカメラを搭載しています。また、LiDAR スキャナー と 深度カメラが搭載されており、これらのカメラやセンサー類が、頭や手のトラッキングを可能にし、リアルタイム3Dマッピングなど高度な処理を実現に貢献しています。

高性能なアイトラッキングは赤外線カメラとLEDイルミネーターを利用することで、LEDが見えない光のパターンを目に投射し、反応が良い直感的な入力を可能にします。そしてApple Vision Proには、省電力で且つ、高速な処理を可能とするApple シリコンチップを2つ搭載しています。1つはM2、もう1つはR1という新しいチップになります。

R1はApple Vision Proに搭載している12個のカメラ、5つのセンサーと6つのマイクからの情報を処理します。R1はセンサーとディスプレイ間の遅延をほとんどなくし、映像酔いを起こさないように設計されたチップです。

Apple Vision Pro のディスプレイは、Appleシリコンのチップに基づいて開発された超高解像度ディスプレイシステムを備えており、micro-OLEDテクノロジーにより、切手サイズの2つのディスプレイに対し、合計2,300万ものピクセルが詰め込まれ、片目あたり、4Kテレビを超えるピクセル数を備えています。

Apple Vision Pro は、空間オーディオシステムを搭載しました。これにより周りの空間から音が出てるように感じられ、リアルな音響効果の体験を可能にしています。Apple Vision Pro は電源につなげれば1日中体験でき、外付けのバッテリーと接続することで、最大2時間使用することができます。

Apple Vision Proならではの新体験を実現する代表的な機能

「Apple Vision Pro」はスマートフォンのような平面的なディスプレイとは全く異なる新しい体験を提供します。それらを実現しているApple Vision Proならではの主な機能を以下に紹介させていただきます。

EyeSight

EyeSightは周囲のつながりと感情を表すことを目的に搭載された機能です。Apple Vision Proを装着して使用しているユーザーが、どのような体験をしているのか?を周囲の人に伝えることができます。

アプリを使用しているときは、Apple Vision Proを装着しているユーザーの目が映し出されます。VRのような没入型のアプリを体験しているときは、目は映らない状態になります。

Apple Vision Pro を装着しているユーザーの近くに人がいると…。視界にその人の姿が自動的に映し出され、Apple Vision Pro を装着しているユーザーの目も映し出されます。

Persona(ペルソナ)

Apple Vision Pro には、自分を映すカメラがありません。リモートでのコミュニケーションをする上で、Persona(ペルソナ)という自分に似た姿を映し出す機能を提供します。

Apple Vision Pro の前面部にあるセンサーを使い、スキャンしてPersona(ペルソナ)用のデータを登録します。登録されたデータをもとに、Apple Vision Proが Persona(ペルソナ) の作成を行います。

作成された Persona(ペルソナ)を自分のアバターとしてFaceTimeで使用することができるようになります。Persona (ペルソナ)はZoomなどの一部のビデオ会議ツールにも組み込まれ、ビデオ会議ツールに関係なく、Persona(ペルソナ)を組み込んだオリジナルのアプリ開発もできます。Persona(ペルソナ)についてこちらでも紹介しています。https://ar-marketing.jp/apple-vision-pro-persona/

「visionOS 2」によりリリースされた新機能

ここからは、WWDC24で同時に発表された「visionOS 2」についても、その機能を紹介していきます。

visionOS 2 の新機能紹介1 – 写真アプリ(Photo)

撮影した写真を空間写真へ

iPhoneなどで撮影した写真をvisionOS2の写真アプリ上でタップするだけで空間写真になります。

先進的な機械学習により。2D画像から空間写真へと生成する機能を実現することができました。

visionOS 2 の新機能紹介2 – 機能性の向上

ホームビューの起動が簡単に

visionOS 1では、デジタルクラウンを押してホームビューを起動していましたが、visionOS 2では手のひらに上げてタップするとホームビューを起動できます。

時刻、バッテリー残量、コントロールセンターの起動が簡単に

時刻やバッテリーの表示は、手のひらを返してみることができたり、タップしてコントロールセンターを表示することもできます。

Mac バーチャルディスプレイのバージョンアップ(visionOS 2.2の機能)

ディスプレイの解像度とサイズがアップします。このバージョンアップで超ワイドディスプレイも実現できます。

トラベルモードの電車対応

トラベルモードは電車にも対応します。

visionOS 2 の新機能紹介3 – 空間ビデオ

空間ビデオ対応のカメラレンズ

キャノンのEOS R7デジタルカメラ用の空間レンズがリリースされます。

空間ビデオ対応アプリ

Final Cut Pro で空間ビデオの編集が可能になります。

visionOS用のVimeoアプリ共有視聴ができます。

visionOS 2 の新機能紹介4 – Apple Immersive Video

空間オーディオと180度の8Kビデオで高品質でかつ没入ビデオ体験を可能にした。Apple Immersive Video。

Blackmagic カメラとDaVinci Resolve Studio、Apple Compressorによる新しい制作ワークフローを構築。これらが年内利用できるようになります。

visionOS 2.4 の新機能紹介 – Apple Intelligence

2025年4月、Appleは空間コンピューティングデバイス「Apple Vision Pro」をvisionOS 2.4にアップデートし、iPhoneやiPadで話題となったAI機能「Apple Intelligence(アップル・インテリジェンス)」を初めて標準搭載しました。ユーザーはメールやメモ、サードパーティ製アプリなどで、文章の書き直し・校正・要約・自動生成をAIにより簡単に行うことができます。さらに、画像生成ツール「Image Playground」を使えば、テーマや場所、アクセサリを選んでオリジナル画像を作成可能です。「Genmoji(ジェン文字)」機能では、音声やテキストの入力から自分だけの絵文字を作成・共有でき、より個性的なコミュニケーションが実現します。

また、メッセージやメールでは文脈に応じたスマート返信や、質問の自動抽出も可能です。写真アプリでは、自然言語による検索やAIによるメモリームービー生成により、思い出の整理と表現がこれまで以上にスムーズになります。visionOS 2.4がもたらすApple Intelligenceは、Apple Vision Proの空間コンピューティング体験を飛躍的に進化させる画期的なAI機能群です。

すべてのAI処理は基本的にデバイス上で行われ、必要に応じてApple独自の「プライベートクラウドコンピューティング」が利用されます。これにより、高精度なAI体験と高度なプライバシー保護を両立しています。

Apple Intelligenceで文章を最適化!書き直し・校正・要約機能を活用「Writing Tools」

Apple Intelligenceは、メールやメモ、他社製アプリなど、あらゆる文章作成の場面で活用できるAI機能です。書き直し、校正、要約を通じて、文章の質を向上させ、言葉づかいを洗練させることができます。

- 書き直し機能:フレンドリー、プロフェッショナル、簡潔など、目的に応じたトーンに調整可能。「変更を説明」機能を使えば、具体的な修正指示もできます。

- 校正機能:文法や表現、構文のチェックを行い、最適な編集候補を提案。

- 要約機能:選択したテキストを、用途に応じた複数の形式で要約可能。

Apple Intelligenceを活用すれば、より魅力的で伝わりやすい文章が簡単に作成できます。

Apple IntelligenceとChatGPTで文章作成を強化!

ChatGPTを使えば、アイデア出しから記事作成まで、多様なコンテンツを生成できます。

これらのAI機能を組み合わせることで、よりスムーズかつ高品質な文章作成が実現します。

Image Playgroundで簡単にユニークな画像を作成!Apple Vision Proにも対応

Image Playgroundでは、テーマ、衣装、アクセサリ、場所を自由に選び、楽しくユニークな画像を簡単に作成できます。さらに、オリジナルのテキスト説明を追加したり、写真ライブラリの画像を活用して家族や友人に似たイメージを生成することも可能です。

この機能は、メッセージ、フリーボード、Keynoteなどのアプリに直接統合されているほか、Apple Vision Pro専用アプリとしても提供されています。直感的な操作で、誰でも魅力的なビジュアルコンテンツを作成できます。

visionOS版のPlayground。#AppleVisionPro pic.twitter.com/r2JO6l8oKt

— Sadao Tokuyama (@tokufxug) February 22, 2025

Image Playgroundの画像生成機能をアプリに組み込むことができる!

Apple IntelligenceのImage Playgroundは、アプリに簡単に組み込める強力な画像生成機能を提供します。テキスト入力による画像生成はもちろん、写真アプリの画像やインターネット上の画像をもとに生成することも可能です。さらに、Apple Pencilで描いた絵を基にした画像生成にも対応し、クリエイティブな表現をより自由に拡張できます。

この機能を活用することで、画像編集アプリ、AIアートアプリ、ビジュアルコンテンツ制作ツールなど、さまざまなアプリ開発が可能になります。

Apple Vision Pro | AppleのAI (Apple Intelligence)の画像生成をアプリに組み込む という記事を書きました。

iOS 18.4 BetaやvisionOS 2.4 Betaの画像生成AI新機能の使い方を解説。https://t.co/6GFH4yxvpC #AppleVisionPro #appleintelligence pic.twitter.com/mlEr8dSHo9

— Sadao Tokuyama (@tokufxug) February 22, 2025

開発方法は以下の記事に掲載されています。

Apple Vision Pro | AppleのAI (Apple Intelligence)の画像生成AI機能をアプリに組み込む

Apple Intelligenceの今後

Appleは、Apple Vision Proでの利用を2025年4月から開始しております。しかし、現時点では英語(米国)のみサポートされており、日本語には対応していません。今後1年以内には、さらに多くの機能が追加され、追加言語にも対応予定です。この進化により、Apple Vision Proを利用するユーザーは、より多彩な言語でAI機能を活用できるようになり、さらに便利な体験を享受できるようになります。

visionOS 2 その他の機能

Apple 公式のvisionOS2 の細かな機能について紹介しています。

https://www.apple.com/jp/visionos/visionos-2/

https://1planet.co.jp/tech-blog/applevisionpro-oneplanet-wwdc24-japan-0628-visionos2

vision OS 2により、Apple Vision Proで体験できること/開発できることは飛躍的に広がりました。最新のvision OS 2に対応したアプリケーションの開発には高度な専門性が求められるため、もしご興味をお持ちの際には専門性を持った開発会社に相談をすると正しい技術選定やアプリケーション開発が実現できるでしょう。

ARグラスのアプリケーション開発において企画から開発までワンストップで提供していますので、ご興味がございましたらお気軽に相談ください。

Apple Vision Pro の開発方法について

Apple Vision Proでアプリや体験を提供するためには、いくつかの開発方法があります。以下に主なものをご紹介します。

Xcode

Apple Vision Pro の開発は、visionOS SDKを含むXcodeで始まります。既存のプロジェクトにvisionOSターゲットを追加するか、新しくApple Vision Pro の アプリを開発。Xcode PreviewsでApple Vision Pro の アプリを繰り返し開発することができます。全く新しいvisionOSシミュレータでアプリを操作し、様々な部屋のレイアウトや照明条件を行えます。テストとビジュアライゼーションを作成して、空間コンテンツの衝突、オクルージョンの動作検証も行うことができます。https://developer.apple.com/xcode/

Swift UI

SwiftUIは、iOS、iPadOS、macOSなどのプラットフォームに適応可能なユーザーインターフェイスを作成することができます。宣言的な構文やデザインツールによって、コードを素早く構築してテストすることができます。UIKitや他のテクノロジーを使ってApple Vision Pro アプリ開発を行うとは可能ですが、SwiftUIはApple Vision Pro のアプリ開発において最適化されたデファクトスタンダードなフレームワークになります。https://developer.apple.com/jp/xcode/swiftui/

RealityKit

Apple Vision Pro 開発で作成したアプリは、奥行きと無限のキャンバスを活用して、没入感のあるパワフルな瞬間を作り出すことができます。Apple Vision Pro で開発したアプリをよりリッチに表現する上で、3Dモデルの表示は欠かせません。3Dモデルを開発したApple Vision Pro のアプリに組み込む開発ツールとして、RealityKitが用意されています。RealityKitはApple VIsion Pro 用の3Dレンダリングエンジンで、シャープで応答性の高い、ボリュメトリックなインターフェースを構築するために提供しています。SwiftUIとも深く統合しています。https://developer.apple.com/jp/augmented-reality/realitykit/

ARKit

ARKitは、Appleが開発した拡張現実のフレームワークです。カメラやセンサーを使用して、現実世界にCGや映像を重ね合わせ、拡張現実(AR)の体験を実現します。ARKitの機能により、バーチャルコンテンツをテーブルの上に配置したり、手で触れたりすることができ、バーチャルコンテンツが現実世界と相互作用することが可能になります。

以下はARKitで開発できる主な機能を紹介します。

Shared Space

Apple Vision Proは、デフォルトで「Shared Space」で起動します。Shared Spaceでは、ARKitによってシステムのコア機能が駆動しているため、ユーザーはARKitの恩恵を自動的に受けることができます。ただし、Shared Space内のアプリは、ARKitのデータを取得や利用できません。

Full Space

Apple Vision ProのFull Spaceでは、ARKitの機能を利用して、周囲の環境とバーチャルコンテンツを組み合わせることができます。Full Spaceで利用できるARKitの機能を紹介します。

Plane detection

Apple Vision Pro (visionOS)の ARKitで平面検出(Plane Detection)(サンプルコード&Xcodeプロジェクト付)という記事を投稿しました。https://t.co/alSXqW1OMb #applevisionpro #visionpro #visionos #oneplanet pic.twitter.com/2To3ljCR9k

— Sadao Tokuyama (@tokufxug) February 15, 2024

ARKitを使用することで、平面を検出します。これには壁、床、天井、テーブル、シート、窓、ドアなどが含まれ、各場所に3Dオブジェクトを配置したり、簡単な衝突検出などに活用できます。

Scene reconstruction

ARKitは現実世界の形状をメッシュとして認識できます。このメッシュを使用することで、高度な衝突検出が実現します。平面、階段、ベッド、キャビネット、家電、テレビ、植物など、複雑な形状も検出し、メッシュが生成されます。

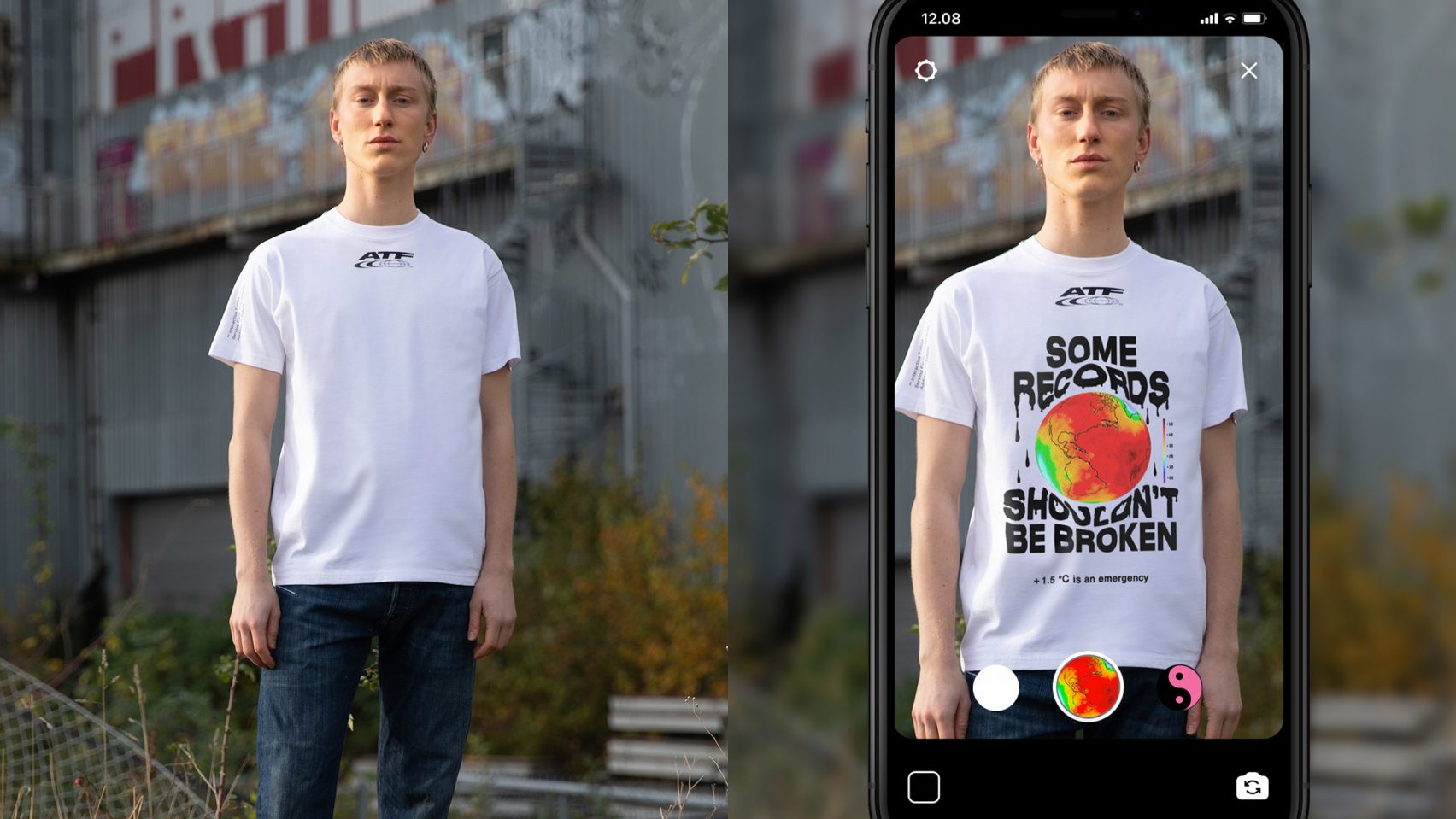

Image tracking

Apple Vision Pro (visionOS)の ARKitで画像トラッキング(Image tracking)(サンプルコード&Xcodeプロジェクト付)の技術記事を投稿しました。#applevisionpro #visionpro #visionos #oneplanet pic.twitter.com/TBz9V7Af3y

— Sadao Tokuyama (@tokufxug) March 5, 2024

ARKitの画像トラッキングでは、事前に登録された画像を検出することも可能です。特定の画像が配置されている場所に3Dオブジェクトを配置できます。

World tracking

Apple Vision Pro (visionOS) で床と壁と天井を認識してモデルを配置する方法(サンプルコード&Xcodeプロジェクト付)という記事を投稿しました。https://t.co/EZ9EFbaAzx #applevisionpro #visionpro #visionos #oneplanet pic.twitter.com/YGhiMfRdXK

— Sadao Tokuyama (@tokufxug) March 22, 2024

World trackingは、現実世界にバーチャルコンテンツを固定できます。ARKitは、Apple Vision Pro の動きを追跡し、バーチャルコンテンツを同じ場所に留まるようにします。

Hand tracking

Apple Vision Pro (visionOS)の ARKitでハンドトラッキング(Hand tracking)(サンプルコード&Xcodeプロジェクト付)の技術記事を投稿しました。https://t.co/FMKIk5cAeM #applevisionpro #oneplanet pic.twitter.com/3NYk7nEkub

— Sadao Tokuyama (@tokufxug) February 19, 2024

手の骨格データを取得することができ、これを使用してカスタムジェスチャーを実装できます。

Object Tracking

Apple Vision Pro (visionOS2) の ARKit オブジェクトトラッキング(物体追跡)についてhttps://t.co/Tb6plXBN0A #applevisionpro #visionpro #visionos #wwdc24 #oneplanet @OnePlanet_AR pic.twitter.com/KZRtyhiyb3

— Sadao Tokuyama (@tokufxug) June 12, 2024

https://1planet.co.jp/tech-blog/applevisionpro-oneplanet-visionos2-object-tracking

Room Tracking

Apple Vision Pro(visionOS2)ARKit ルーム トラッキングは、部屋の間の移動を認識できます。新しい部屋に入ると、Room tracking(ルームトラッキング)が、その部屋のデータに切り替わります。https://t.co/ao1RLAzZKj #applevisionpro #visionpro #visionos #wwdc24 #oneplanet @OnePlanet_AR pic.twitter.com/9tv8K3lREe

— Sadao Tokuyama (@tokufxug) June 15, 2024

https://1planet.co.jp/tech-blog/applevisionpro-oneplanet-visionos2-arkit

Reality Composer Pro

Apple Vision Pro アプリの 3Dコンテンツのプレビューや編集を可能にするアプリケーション Reality Composer Pro。Xcodeで利用できるReality Composer Proは、3Dモデル、マテリアル、サウンドなどのアセットのインポートが可能です。Reality Composer Pro は、Xcodeのビルドプロセスと緊密に統合され、Apple Vision Pro のアセットをプレビューして最適化することができます。

Unity

いままで紹介していた開発ソフトウェアは、Apple社が、iOS、iPad OS、macOSのアプリ開発者向けに提供しているものになります。Androidや他のプラットフォームのアプリやゲーム開発でよく使用されているゲームエンジン、Uniry Editor。このUnity EditorもApple Vision Pro の 開発をサポートしています。(AR Foundationも利用できます。)

まとめ

Apple Vision Proは、アップルグラスとして期待されていたARグラスの進化形であり、次世代空間コンピューターとして注目を集めています。

本記事では、日本で2024年6月に発売されたApple Vision Proについて、基本的な仕様や特徴から、OnePlanetが渋谷パルコで手がけた先進的なイベント事例まで幅広く紹介しました。このデバイスは、空間全体をインターフェースに変える革新的な体験を提供し、EyeSightやPersonaなどの新機能を通じて、ARやVRの可能性を大きく広げています。

また、互換モードによる既存アプリの活用や、visionOSと連携した開発環境の利便性など、Apple Vision Proがもたらす開発者とユーザーの双方にとってのメリットも明らかになりました。特に、SwiftUIやRealityKitを活用したアプリ開発が、これまでにない没入型の空間体験を可能にします。

visionOS 2.4では、Apple Vision ProにApple Intelligenceが標準搭載され、より豊かな体験が提供されます。Apple Intelligenceは、文章の書き直し・校正・要約に加え、画像生成機能も提供しており、ユーザーは多様なコンテンツ作成を効率よく行えます。また、Image Playgroundを活用すれば、写真や絵をもとに独自の画像を生成でき、アプリに簡単に組み込むことが可能です。これにより、開発者はAIアートアプリや画像編集ツールを作成することができます。

現在、Apple Vision Proでの利用は、英語(米国)のみサポートされていますが、追加機能や多言語対応が進むことで、より多くのユーザーがその利便性を享受できるようになります。Apple Vision ProとApple Intelligenceの未来は、さらなる進化を遂げ、私たちのクリエイティブな体験を革新することでしょう。

Apple Vision Proは、未来の生活や仕事のスタイルを根本から変える可能性を秘めたデバイスです。AppleGlassや空間コンピューターの可能性に興味がある方は、このデバイスが提供する新たな体験をぜひチェックしてみてください。視覚的なインターフェースと直感的な操作が織りなす未来のコンピューティング体験を、実際に体感してみる価値があります。

Android XR について

スマートフォンの世界でシェアを2分するiPhoneとAndroidですが、iPhoneを開発するAppleについては本記事で紹介をした「Apple Visino Pro」の提供を開始しました。

そして、もう一方のGoogleについても、2024年末に「Android XR」を発表しました。Android XRについてもご興味のある方は、こちらをご覧ください。

AR に関するお問い合わせ

本メディア「ARマーケティングラボ」を運営する株式会社OnePlanetでは、ARに特化したスタートアップとしてARグラスを活用したアプリケーション開発について豊富な実績を有しています。

記事の冒頭の通り、日本初となるApple Vision Proを使ったイベントを手がけている他、様々なARグラスアプリケーションを国内でも先行して開発・提供しています。実績についてはこちらをご覧ください。

ARグラスのアプリケーション開発において企画から開発までワンストップで提供していますので、ご興味がございましたらお気軽に相談ください。