Apple社がアップルグラスというARグラスの開発を噂されていましたが、2024年2月2日にアメリカでAppleの空間コンピューティングデバイス「Apple Vision Pro」として正式にリリースされ、2024年6月28日に日本でリリースでもリリースされました。今回、Apple Vision Proのアプリ開発に必要なアセット作成とヒントについて紹介します。

目次

- アップルグラスというARグラスの開発を噂されていた 「Apple Vision Pro (アップル ビジョンプロ)」何ができる?

- 日本初となるApple Vision Pro(アップル ビジョンプロ)を実際に体験できるイベントを開催

- DCCツールについて

- GPUのレンダリング

- Apple Vision Proでの推奨ポリゴン数上限

- カメラの設定と配置のポイント

- 座標系について

- Apple Vision Pro の カラースペース(色空間)

- 法線マップについて

- リアルタイムライトよりベイク処理

- 透明マテリアルについて

- 完全没入型のドーム作成について

- Image Base Light のテクスチャ画像について

- まとめ

- AR に関するお問い合わせ

アップルグラスというARグラスの開発を噂されていた 「Apple Vision Pro (アップル ビジョンプロ)」何ができる?

そもそもアップルグラスというARグラスの開発を噂されていた「Apple Vision Pro は何ができる?」という方には、以下の記事で概要について説明しています。

日本初となるApple Vision Pro(アップル ビジョンプロ)を実際に体験できるイベントを開催

日本ではまだ発売前だった「Apple Vision Pro」を、日本国内で先行したプレイヤーのビジネスが展開されています。

2024年2月時点で、ARに特化したスタートアップである株式会社OnePlanetはいち早く渋谷PARCOで本デバイスを活用した日本初となるイベントをウォルト・ディズニー・ジャパンと手がけており、他では体験できない感動レベルの空間体験が話題を集めました。

この時点でデバイスは国内では購入できないため、海外から取得したデバイスを特別な許可を得てイベントで展開していました。詳細は以下のリリースからご覧ください。

プレスリリース:https://prtimes.jp/main/html/rd/p/000000055.000049853.html

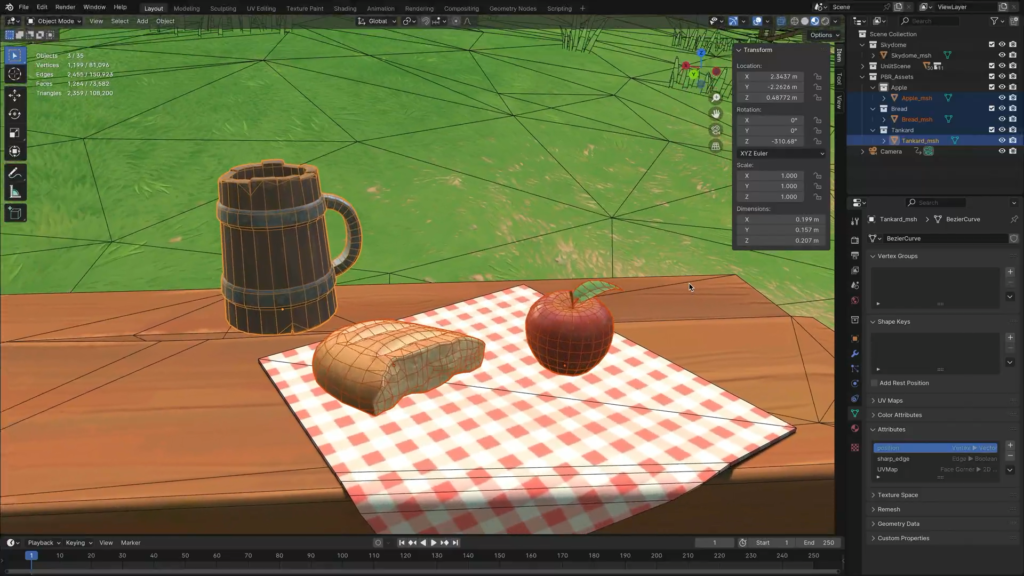

DCCツールについて

Apple Vision Proのアプリ開発では、3D形式としてUSD(Universal Scene Description)のみがサポートされています。そのため、使用するDCCツール(デジタルコンテンツ作成ツール)はUSD形式で保存できるものでなければなりません。USD形式で保存できる代表的なDCCツールは次の通りです。

- Blender

- Autodesk Maya

- SideFX Houdini

なお、Appleが提供するApple Vision Proの開発用フレームワーク「RealityKit」はUSD形式のみをサポートしています。一方、Unity Editorでは、Unity PolySpatialがサポートする3Dモデルを使用する形になります。

GPUのレンダリング

Apple Vision ProのGPUは、実際にレンダリングするピクセルだけを処理します。つまり、カメラからの映像(パススルービデオ)には処理を行いません。

パススルービデオ(カメラからの映像)を使った体験から完全没入型の体験に切り替えると、Apple Vision ProのGPUは画面全体をレンダリングする必要があります。そのため、現実空間での体験に比べてGPUの処理コストが高くなります。

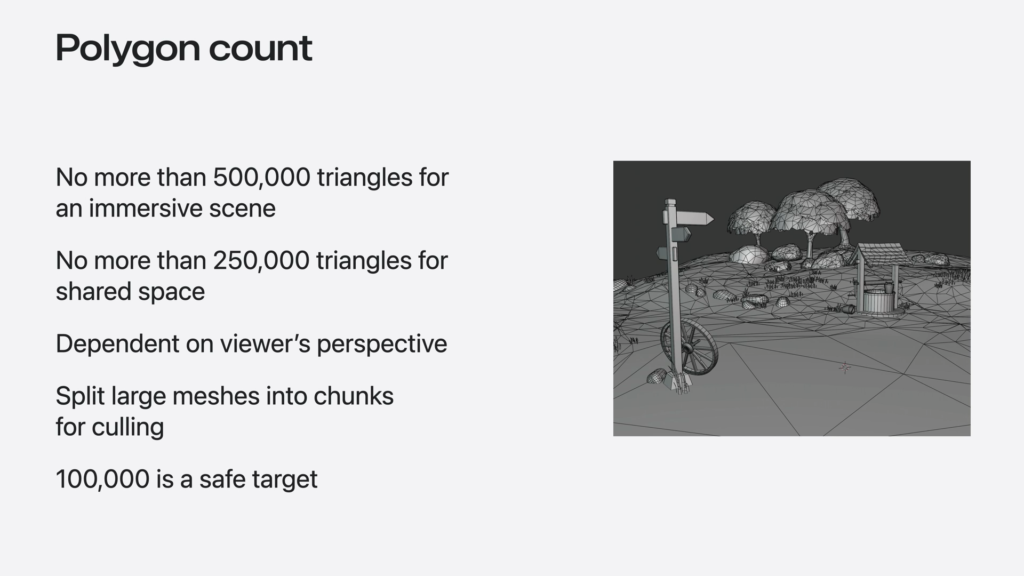

Apple Vision Proでの推奨ポリゴン数上限

Apple Vision Proのパフォーマンスを最適化するためには、以下のポリゴン数の上限を守ることが重要です。

- Shared Space(共有スペース)のアプリ

Safariや地図アプリなど、1つのスペースに複数のアプリを同時に起動する場合、ポリゴン数の上限は25万個を推奨します。 - Full Space(フルスペース)のアプリ

1つのアプリが画面全体を占有する場合(例えば、ARKitを使ったARアプリやVRアプリなど)、ポリゴン数の上限として50万個を推奨します。 - 視野内のポリゴン数

視野内に表示されるポリゴン数の上限は10万個を推奨します。

これらのガイドラインに従うことで、Apple Vision Proでのアプリのパフォーマンスを安定して保つことができます。

カメラの設定と配置のポイント

BlenderなどのDCCツールを使用してApple Vision Proの3Dアセットを作成する際、Apple Vision Proを装着したユーザーの視点を確認するには、カメラをユーザーの目の高さに設定します。具体的には、カメラを高さ1.5メートルに配置してチェックします。

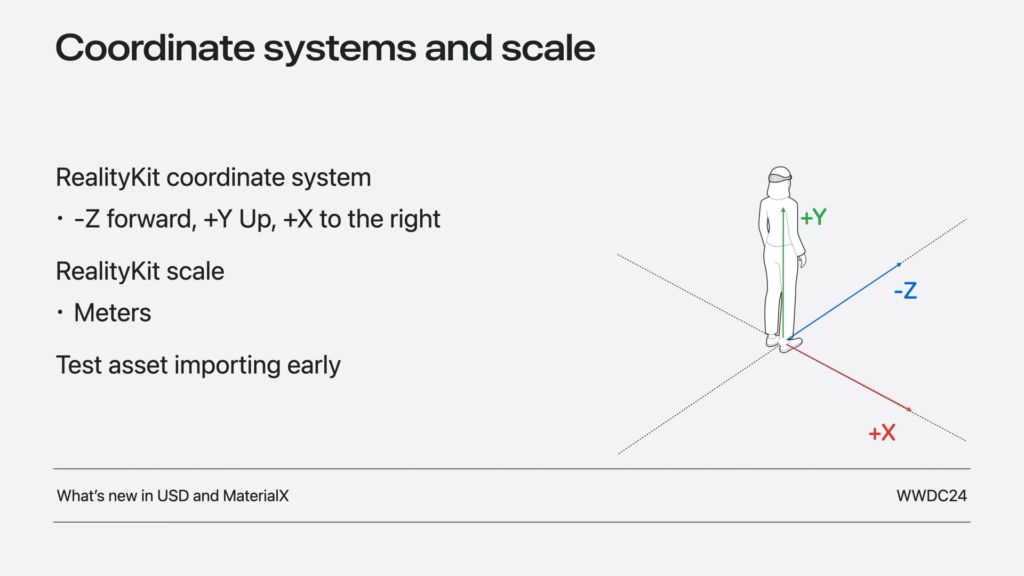

座標系について

RealityKitとDCCツールでは座標系が異なるため、それぞれの座標系の違いを事前に把握しておくことが重要です。

RealityKit

+X(右), +Y(上), +Z(手前)

-X(左), -Y(下), -Z(奥)

Blender

+X(右), +Y(奥), +Z(上)

-X(左), -Y(手前), -Z(下)

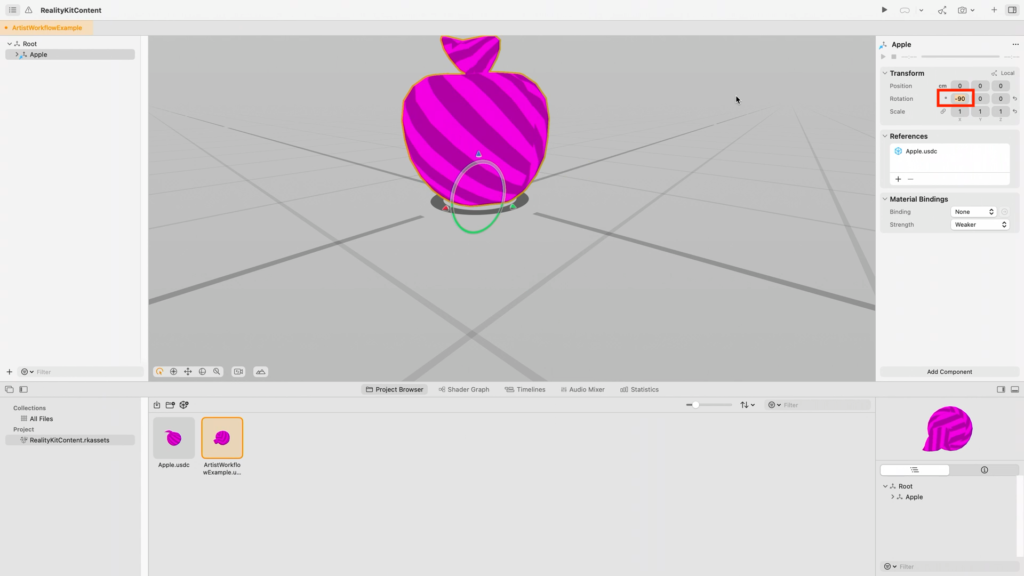

Blenderで作成したモデルをReality Composer Proで読み込む場合、X軸を-90度回転させる必要があります。これにより、座標系の違いによる位置ずれを修正できます。

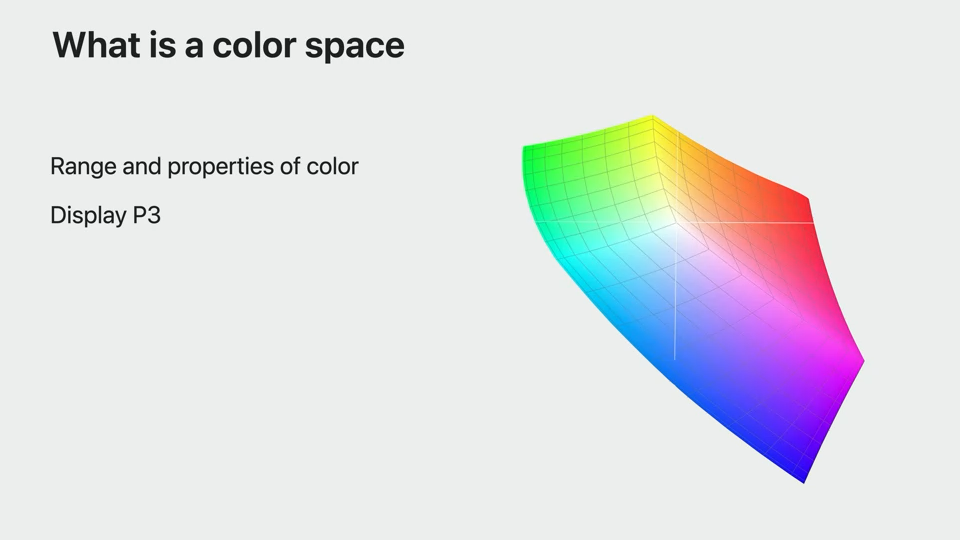

Apple Vision Pro の カラースペース(色空間)

Apple Vision Proは、Display P3という広い色域を持つカラースペースを標準で使用しています。他のカラースペースで作成したテクスチャは、Xcodeでアプリをビルドする際にDisplay P3に変換されます。

テクスチャを作成する際には、テクスチャが意図した色を正確に表現できるように、色の設定を適切に行うことが重要です。これにより、アプリ内で色の見え方が一貫します。

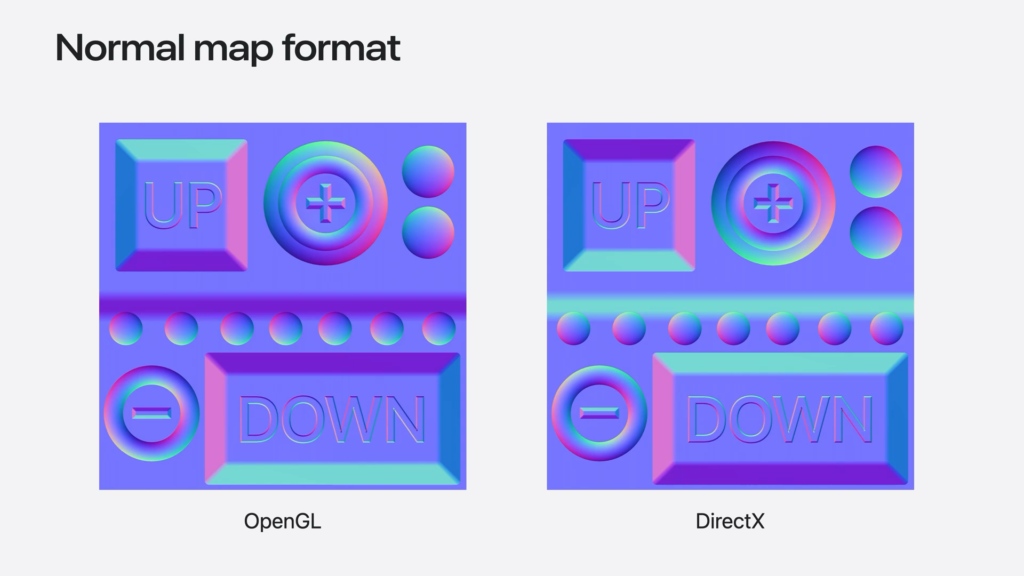

法線マップについて

RealityKitはOpenGL形式の法線マップを使用しています。DirextXの法線マップぼ場合、緑のチャンネルが反転されます。

リアルタイムライトよりベイク処理

リアルタイムのライトはパフォーマンスに影響を与えるため、動的なライトの使用は避け、可能な限りベイク処理をしてください。

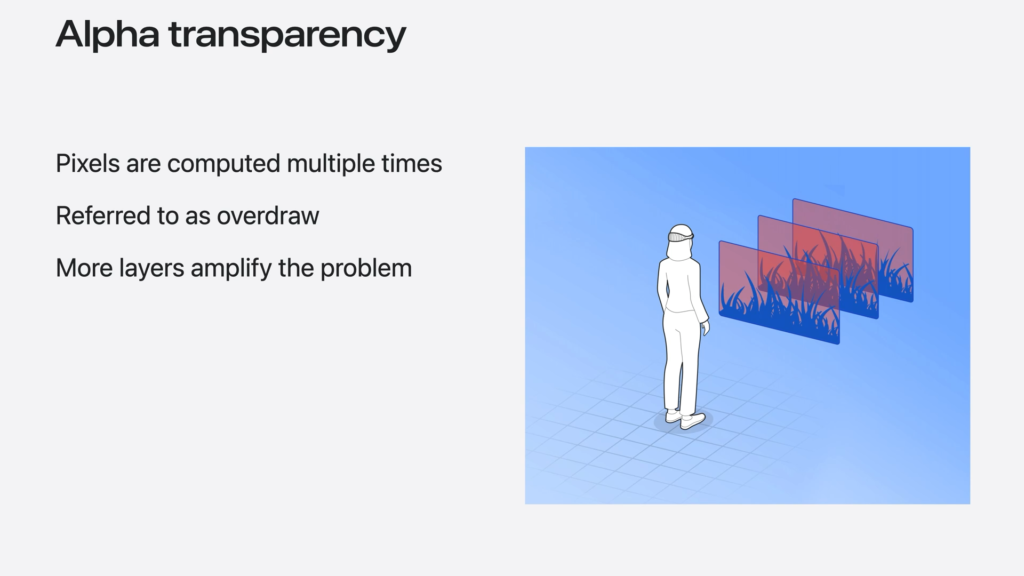

透明マテリアルについて

GPUは、透明なレイヤーごとに同じピクセルを複数回計算する必要があるため、処理コストが高くなります。これを「オーバーロード」と呼びます。特に、透明なレイヤーが多く重なっていると、計算処理が非常に多くなります。

例えば、草や木の葉を作成する際には、透明なマテリアルを多用するよりも、ポリゴン数を増やしてモデルを作成した方が処理コストが低くなります。ただし、ポリゴン数は推奨値の範囲内で作成することが重要です。

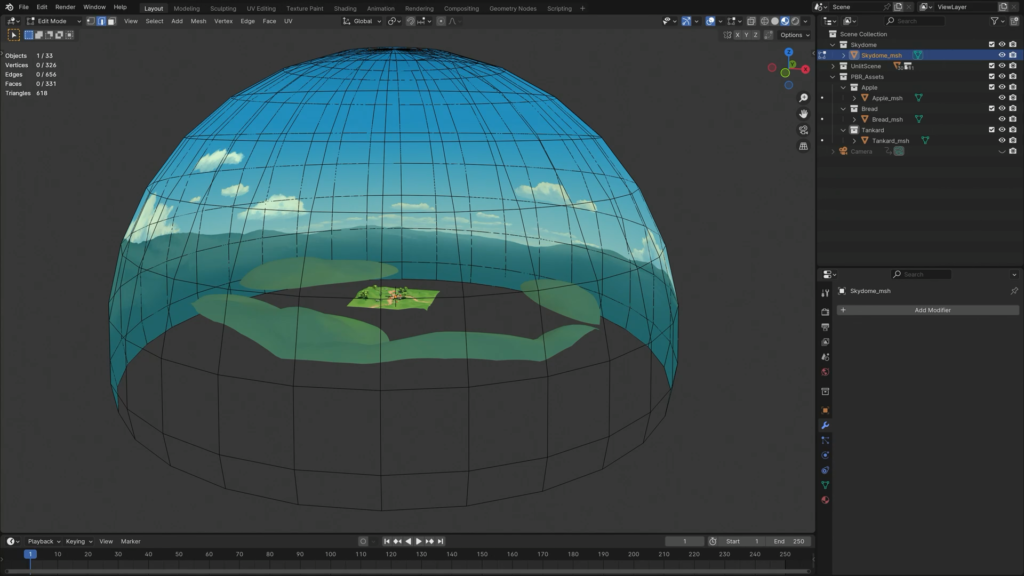

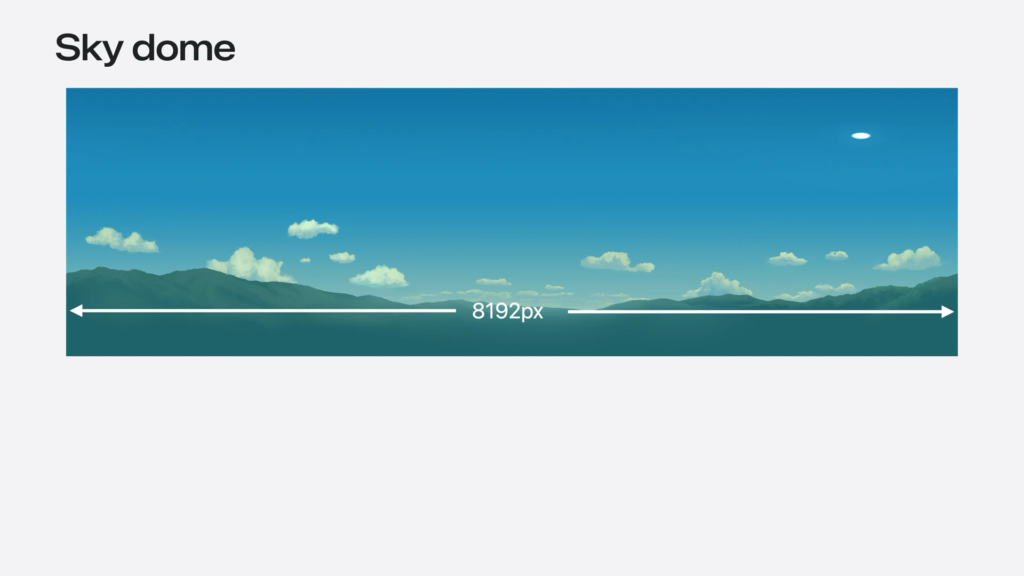

完全没入型のドーム作成について

完全没入型の風景となるドームはスケールを大きく作ります、また、ユーザーの位置から、かなり離れた状態にします。(以下のドームは直径500メートルになります。)

Apple Vision Proで体験した時にぼやけた風景にならないよう高解像度のテクスチャを用意する必要があります。横幅8192px以上の解像度が必要です。しかし、体験時に見えない部分を切り取って、余計な処理を行わないようにします。(画像の下半分で見えないところは切り取ります。)

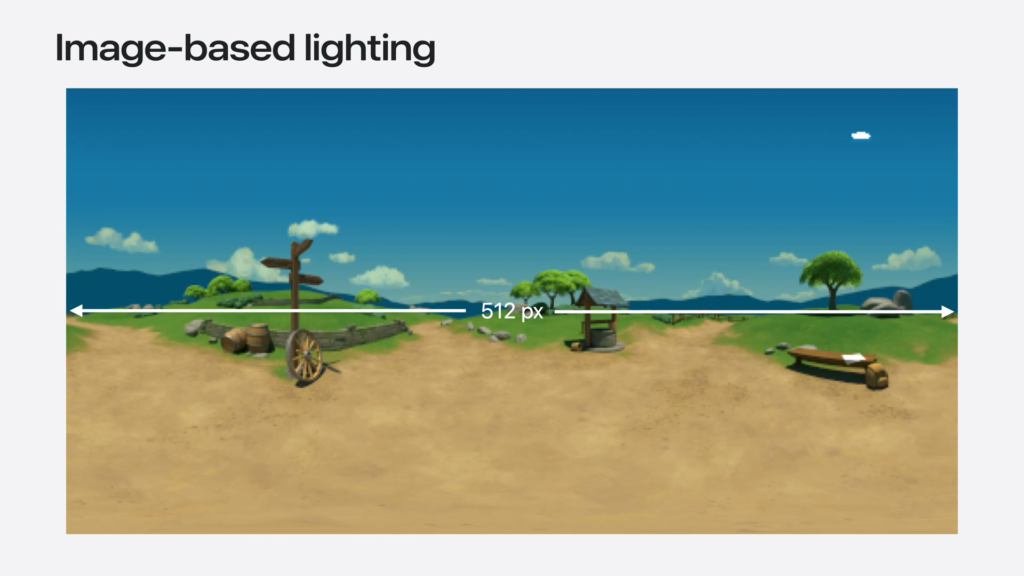

Image Base Light のテクスチャ画像について

風景の全方向の光情報をキャプチャした画像を光源として用いるImage Base Lightは、鏡のような表面でなければ、512pxで十分です。

まとめ

AR に関するお問い合わせ

本メディア「ARマーケティングラボ」を運営する株式会社OnePlanetでは、ARグラスを活用したアプリケーション開発について豊富な実績を有しています。AppleのARグラスについても常に最新の技術情報を収集し、 R&Dを進めており、日本初となるApple Vision Pro を使ったアプリの開発からサポートまで実施しました。

こちらは第96回アカデミー賞4部門に輝いた、映画『哀れなるものたち』(配給:ウォルト・ディズニー・ジャパン株式会社)の公開を記念して渋谷PARCO 3F イベントスペースの特別展示の中で、体験イベントを開催しました。詳細についてはこちらでご確認ください。

企画から開発までAR関連サービスをワンストップで提供していますので、ご興味がございましたらお気軽に相談ください。